Fokus: Die Verwandlung von Big Science

Die neue Offenheit von Big Science

Früher wollte die Forschung mit gewaltigen Projekten Kriege gewinnen. Heute öffnet sich Big Science für wesentlich vielfältigere Aufgaben – und wird attraktiver.

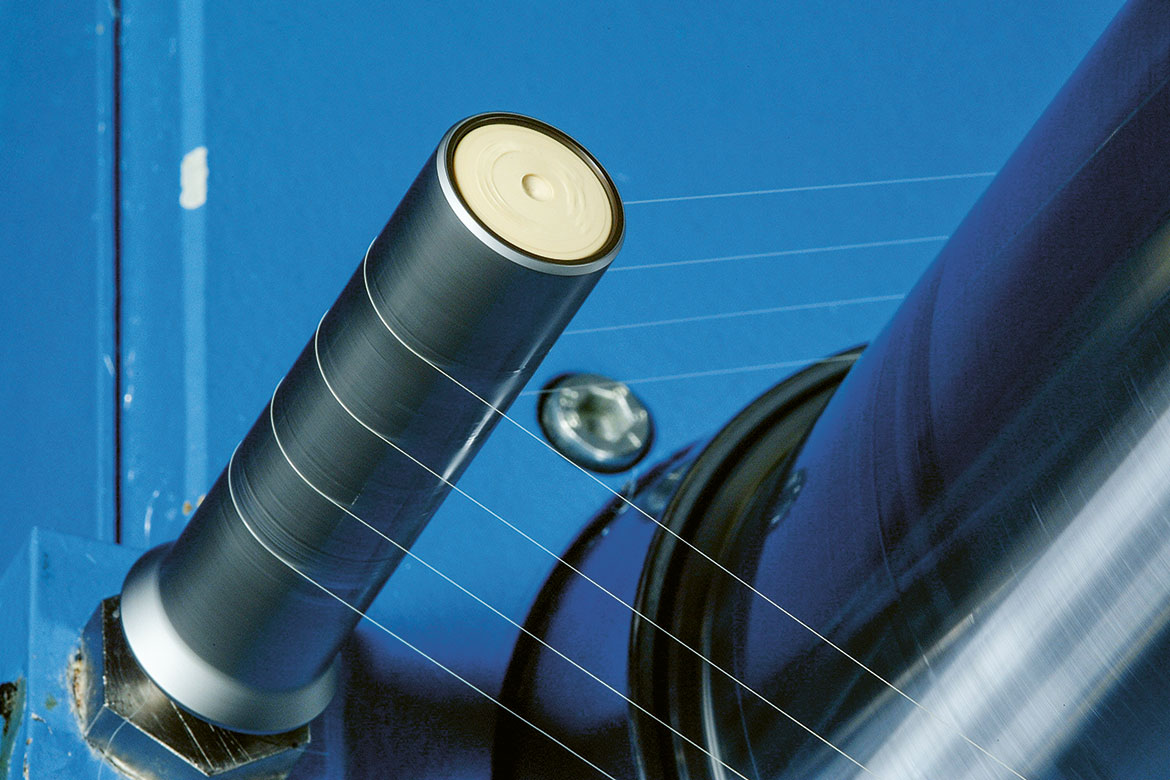

Nicht nur für Teilchenphysiker: Am Beschleuniger treffen sich auch Agronomen, Archäologinnen und Ingenieure | Bild: Aurel Märki

«Big Science. Hallelujah!» 1982 inszeniert die Sängerin Laurie Anderson den Begriff «Big Science» auf der Bühne der amerikanischen Popkultur. «Hallelujah!» – tatsächlich: Diese Art Forschung, die in Teams betrieben wird und sich um gigantische Infrastrukturen dreht, versprüht eine Aura des Sakralen. Geboren wurde Big Science im Zweiten Weltkrieg mit der Entwicklung des Radars und der Atombombe, doch inzwischen hat sie einen Wandel durchlaufen: Heute ist Big Science der Partikelbeschleuniger unter unseren Füssen, die Teleskopnetze in der Wüste und die Satelliten in den Umlaufbahnen über unseren Köpfen. Riesige Labors, ausgestattet mit kolossalen Instrumenten, unter der Schirmherrschaft von Regierungen oder gar Staatengemeinschaften, ergründen seither die Ursprünge des Universums – Physik und Astronomie im Schlepptau.

Zweifellos trägt die Arbeit Früchte. Ein Beispiel ist das Standardmodell der Elementarteilchenphysik, das insbesondere auf das Cern und das Fermilab in den USA zurückgeht, diese «Theorie von fast allem», die mithilfe von einem Dutzend Elementarteilchen die Materie und die Kräfte des Universums beschreibt. Oder das Hubble-Weltraumteleskop, das uns überwältigende Bilder von der Expansion des Kosmos, den Gravitationseffekten der Schwarzen Löcher und den Brutstätten neuer Sterne liefert. Militärische Überlegenheit hat ihre Fortsetzung im kulturellen Prestige gefunden, das sich nun im Hang zum Pompösen ausdrückt. Bereits 1961 verglich der Physiker Alvin Weinberg diese Anlagen mit modernen Kathedralen.

Doch um die Jahrtausendwende begann sich dieser auf Grösse fixierte Ansatz zu diversifizieren. Der Kreis der Akteure öffnete sich gegenüber anderen Disziplinen und der Industrie, und die Steuerung der Big-Science-Projekte wurde demokratisiert. Die Erwartungen und Versprechen im Zusammenhang mit den Megaunternehmungen sind konkreter geworden: Heute ist die Rede von Renditen, regionaler Wirtschaftsförderung und der Lösung gesellschaftlicher Fragen in Bereichen wie Energie, Lebensmittel oder Gesundheit. Und der Grössenbegriff ist inzwischen verschwommen: Heute wird Big Science auch mit bescheideneren Mitteln und Small Science auch mit gigantischen Teilchenbeschleunigern (Synchrotronen) realisiert.

Archäologie am Beschleuniger

«Was heute ins Auge sticht, wenn man ein Zentrum wie das Argonne National Laboratory in Illinois besucht, wo sich eines der drei grössten Synchrotronen der Welt befindet, ist die Vielfalt der Nutzer», sagt Catherine Westfall, Wissenschaftshistorikerin an der Michigan State University und Verfasserin mehrerer Studien über die Entstehung der Mega Science. Während solche Beschleuniger früher ausschliesslich im Dienst der Teilchenphysik standen, hat sich ihre Anwendungspalette inzwischen erheblich erweitert. «Ich habe Agronomen getroffen, die Saatgut entwickelten, Archäologinnen auf der Suche nach neuen Grabungstechniken und einen Wissenschaftler bei der Entwicklung eines Flugzeugtriebwerks, das Zusammenstössen mit Vögeln standhält.» Teilchenstrahlen dienen immer häufiger dazu, praktische Anwendungen von Materialien, etwa von Metallen oder Proteinen, zu erforschen. Westfall erklärt weiter: «Die Biomedizin ist heute die Vorzeigedisziplin, deren Infrastrukturen am meisten Forschende anziehen und in der sich die Mittelbeschaffung am einfachsten gestaltet.»

In diesem Prozess verwischen sich die Grenzen zwischen Megainfrastrukturen und Forschungsprojekten. Olof Hallonsten, Soziologe und Wissenschaftshistoriker an der schwedischen Universität Lund, Verfasser eines wissenschaftlichen Werks zu den Metamorphosen der Big Science, vergleicht zwei Momente, wenn er auf diese Wende zu sprechen kommt: «1984 erhielten Carlo Rubbia und Simon van der Meer den Nobelpreis für die Entdeckung der W- und Z-Bosonen. Diese Auszeichnung wird zwar Personen verliehen, sie kam in diesem Fall aber auch dem Forschungszentrum zugute, an dem die Entdeckung stattgefunden hatte: dem Cern.» 25 Jahre später präsentierte sich die Situation anders: «2009 erhielten die Molekularbiologin Ada Yonath und ihr Team den Nobelpreis für Chemie für ihre Arbeit zu den Ribosomen der Zellen. Ein halbes Dutzend Forschungszentren aus aller Welt erklärten daraufhin in Medienmitteilungen, dass diese Arbeiten nur dank ihrer Grossanlagen möglich waren.»

Nach dem Auswahlverfahren durch die Verantwortlichen aus Wissenschaft, Politik und Industrie werden 2020 ein oder zwei Projekte lanciert. Die EPFL koordiniert bereits das Human Brain Project, das 2013 gleichzeitig mit dem zweiten Flagship-Projekt Graphene startete. Das der Quantentechnologie gewidmete Programm Quantum beginnt 2019.

Immer häufiger wird «Small Science mit grossen Werkzeugen realisiert», beobachtet Olof Hallonsten. Anstelle von Forschungszentren, die für ein Megaprojekt gegründet werden, treten grosse Plattformen ohne präzises Ziel, die sich an den Bedürfnissen der Nutzer orientieren: «Die meisten Forschenden, die diese Zentren nutzen, haben ihre Stelle und Finanzierungsquelle an einem anderen Ort. Sie arbeiten normalerweise mit kleineren Geräten, benötigen aber punktuell eine Grossanlage. Sie stellen ein Gesuch, müssen sich gegen andere Interessenten durchsetzen und erhalten dann, wenn alles gut geht, Zugang zur Anlage. Sie führen ihre Experimente durch und nehmen ihre Ergebnisse mit. In diesem Modell sind Grossbeschleuniger oder -reaktoren nicht mehr Teams vorbehalten, deren Mission es ist, Kriege zu gewinnen oder die Ursprünge des Universums aufzuspüren. Vielmehr stellen sie eine Ressource dar, die grundsätzlich allen offensteht. Das Modell ist demokratischer und weniger von politischen oder militärischen Entscheidungen abhängig.»

Blütezeit der Konsortien

Die Entkopplung zwischen Projekt- und Infrastrukturdimension vollzieht sich auch in umgekehrter Richtung: Big Science mit Megabudgets und Megazielen ist auch ohne Megainstrumente möglich. Dies ist zum Beispiel der Fall beim Human Genome Project und in der Biologie allgemein. Eine Zeit lang versuchte diese Wissenschaft der Physik mit ihrem Drang nach Rekorddimensionen nachzueifern, sagt Bruno Strasser, Professor für Wissenschaftsgeschichte an der Universität Genf und Verfasser mehrerer Studien zur Geschichte der Biomedizin sowie zu Big Data und zur partizipativen Forschung. «Bei der Eröffnung des Europäischen Laboratoriums für Molekularbiologie (EMBL) in Heidelberg 1974 hegte man die Hoffnung, so etwas wie das Cern der Biologie zu werden – dank der Bereitstellung eines Instruments, das für ein einzelnes Universitätslabor zu kostspielig gewesen wäre, und einer zentralen Fragestellung. Doch diese Zentralisierung wäre gar nicht nötig gewesen, weil die Disziplin keine Grossanlagen verwendet. In der Biologie setzt die Small Science Massstäbe, wie es der amerikanische Biochemiker Bruce Alberts formulierte. Die Forschenden des EMBL verbrachten deshalb ihre Zeit damit, den Daseinszweck der Infrastruktur zu rechtfertigen.» Als sich in der zweiten Hälfte der 1970er-Jahre die DNA-Sequenzierung verbreitete, «versuchte das EMBL die Gelegenheit beim Schopf zu packen und sich damit zu legitimieren: Es rief 1982 die erste öffentliche Datenbank für Gensequenzen ins Leben, die Nucleotide Sequence Database.» Während für die Sequenzierung selbst keine Grossanlagen erforderlich sind, braucht es für die resultierenden Big Data eine leistungsfähige Infrastruktur.

1990 nahm das Human Genome Project (HGP) die vollständige Sequenzierung der DNA in Angriff. Das ambitiöse Ziel und das medizinische Potenzial machten Schlagzeilen. Im Jahr 2000 erklärte US-Präsident Bill Clinton, dass es «durchaus möglich ist, dass für die Kinder unserer Kinder der Krebs nur noch ein Tier ist». In Wirklichkeit ist das Projekt, das als Big Science präsentiert wurde, jedoch eher mit der bescheideneren Dimension eines Biologielabors zu vergleichen. «Es entfernt sich vom Modell eines Cern, das die Ressourcen an einem Ort konzentriert und eine Art geschlossenen Mikrokosmos mit der Bevölkerungszahl einer Kleinstadt bildet», erklärt Bruno Strasser. Am HGP dominieren im Gegensatz dazu räumlich zersplitterte Forschungsinitiativen zahlreicher Institutionen, die sich für diese Gelegenheit in einem internationalen Konsortium zusammenschliessen.

Diese Logik wird heute noch weitergetrieben. Zum Beispiel, so der Schweizer Historiker, mit SystemsX, einer schweizerischen Initiative für Systembiologie, die von einem Forschungskonsortium an mehreren Standorten durchgeführt wird und das bisher grösste Forschungsprojekt des Landes darstellt. Das 2008 lancierte und 2018 endende Projekt basiert nicht auf einer riesigen Infrastruktur und hat sich nicht einem einzigen grossen Ziel verschrieben. Vielmehr geht es um ein ganzes Bündel von Projekten mit einem gemeinsamen Rahmen, wie die von der ETH unterstützte Dissertation von Alban Frei 2017 zeigte. «Die Koordination von SystemsX und ihr Auftritt nach aussen sind jedoch von Big Science inspiriert», erklärt Strasser weiter. «So kümmern sich vollzeitlich angestellte Kommunikationsbeauftragte um das Image der Initiative. Dies ermöglicht es den Forschenden, ihre Arbeiten in einem neuen Licht zu präsentieren und so auch die Öffentlichkeit und die Politik zu erreichen. Für den Dialog mit der übrigen Gesellschaft und die Mittelbeschaffung ist das sehr wertvoll.»

Comeback der Laien

Sich zusammenschliessen, um eine kritische Masse zu erreichen und der Visibilität Impulse zu verleihen – dient dieses Konzept lediglich der Imagepflege? «Einerseits könnte man behaupten, dass die Operation SystemsX nicht einer wissenschaftlichen Notwendigkeit entspricht», antwortet der Genfer Forscher. «Schliesslich weiss niemand genau, was Systembiologie ist. Doch die Initiative stimuliert interessante Forschungsideen. Sie fördert zudem den Austausch, denn wer Geld aus derselben Quelle erhält, spricht eher miteinander. Die einzelnen Projekte dürften vom gemeinsamen Rahmen profitieren, der die verschiedenen Einzelteile zusammenfügt und ein Motiv erkennbar macht. Und sich so gegenseitig befruchten.»

Mit dem Wechsel vom zentralistischen Konzept zum Netzwerkmodell knüpft die Wissenschaft der Megaprojekte gemäss Bruno Strasser an frühere Epochen an: «Im 19. Jahrhundert war Big Science gleichbedeutend mit Biologie. Die Forschungszentren waren die botanischen Gärten und die naturhistorischen Museen in Berlin oder London. Die Grossprojekte hatten das Ziel, die Welt zu erkunden. Hunderte von Personen, die mit Schiffen aus den unterschiedlichsten Ecken der Welt lossegelten, mussten koordiniert, Leute mit verschiedensten Nationalitäten und aus verschiedensten Kulturen zusammengebracht werden, darunter auch viele Laien.»

Auch heute spielen Nichtexperten wieder eine Rolle, und zwar über die partizipative Wissenschaft. «Nach unseren Schätzungen gibt es rund zehn Millionen Menschen weltweit, die sich in einem solchen Rahmen einbringen», fährt der Genfer Forscher fort. «Die Bereiche, in denen die Beteiligung der Allgemeinheit im grossen Massstab stattfindet und rasch wächst, sind dieselben, die schon in der Vergangenheit auf Laien setzten; nämlich die Naturwissenschaften und die Astronomie.» Im Rahmen von Galaxy Zoo beispielsweise beteiligen sich Laien an der Klassifikation von Millionen von Galaxien, andere wirken an Monitorings zur Entwicklung der Biodiversität mit, indem sie Fotos posten, an Studien über den Klimawandel mitarbeiten oder den Zeitpunkt melden, an dem die Bäume im Herbst ihre Blätter verlieren. Diese Bewegung ist sozusagen eine andere Art der Forschung in grossem Stil: Im Rahmen eines Megaprojekts fügen sich Myriaden winziger Einzelbeiträge wie Steinchen zu einem Mosaik zusammen. «Die Mitwirkung der Allgemeinheit an der Forschung, wie sie im 18. und 19. Jahrhundert die Norm war, erlebte im vergangenen Jahrhundert längerfristig betrachtet vielleicht nur eine kurze Finsternis. In dieser Phase konsumierten die Menschen wissenschaftliche Erkenntnisse lediglich und wohnten dem Spektakel der Wissenschaft als Zuschauer bei. Nun sind sie wieder bereit, eine aktivere Rolle einzunehmen.»

Manchmal baut ein partizipativer Ansatz auf einer grossen Datenmenge auf, die durch die professionelle Wissenschaft generiert wurde. Dies ist beim Online-Projekt Annotathon der Fall, bei dem die Teilnehmenden DNA-Sequenzen annotieren, die aus dem Projekt Global Ocean Sampling von Craig Venter stammen. «Die Generierung offener Daten ist einer der Nebeneffekte von Big Science», erklärt Bruno Strasser. «Das Prinzip der Öffnung funktioniert nicht zuletzt, weil es nicht nur auf Idealismus beruht, sondern insbesondere im Rahmen von Konsortien einer Notwendigkeit entspricht. Eine Koordination wäre unmöglich, wenn jeder Teilnehmer seine Daten für sich behalten würde.» Die im Rahmen des Human Genome Project angewendeten Grundsätze von Bermuda (1996) und die Vereinbarungen von Fort Lauderdale (2003) etablieren denn auch die Praxis des Open Access und der sofortigen Freigabe der Daten im Bereich des Genoms.

Grenzen verwischen

Big Science scheint heute also in vielerlei Richtungen gleichzeitig aufzubrechen. Das Beispiel des Global Ocean Sampling widerspiegelt die laufende Verwischung der Grenzen in diesem Bereich. Das Projekt will die genetische Vielfalt der mikrobiellen Population der Meere auf einer weltumspannenden Erkundungstour erheben. Konkret erfolgt die Arbeit mit der relativ bescheidenen Infrastruktur einer privaten Jacht. Initiator Craig Venter ist gleichzeitig Wissenschaftler und Unternehmer: Zum Finanzierungspool gehören private Stiftungen, die TV-Kette Discovery Channel, welche die Expedition in Szene setzt, sowie das US-Department für Energie, das hofft, in den Mikroben innovative Lösungen zur Deckung des landesweiten Energiebedarfs zu finden. Annotathon wiederum stellt die Verbindung zur partizipativen Dimension des Projekts her.

Daneben setzen andere Projekte den klassischen Drang nach Grösse fort. Die meisten werden aber früher oder später mit dem Ruf nach Öffnung und Diversifikation konfrontiert. Das Human Brain Project hat seine atemberaubenden Anfangsversprechen – die Abläufe im menschlichen Gehirn oder sogar das Bewusstsein auf einem Supercomputer zu reproduzieren – auf Eis gelegt und konzentriert sich nun wieder auf die Entwicklung einer Technologieplattform im Bereich der Neuroinformatik.

Die europäische Extreme Light Infrastructure hat die Konstruktion der leistungsstärksten Laser der Welt in Angriff genommen, ohne genaue Forschungsziele zu definieren. Diese werden faktisch den künftigen Nutzern überlassen. Dasselbe gilt für die European Spallation Source (ESS), die derzeit in Schweden um eine gepulste Neutronenquelle aufgebaut wird, die 30-mal stärker als die aktuellen Geräte werden soll. Auch die ESS orientiert sich am neuen Paradigma der «kleinen Wissenschaft mit grossen Werkzeugen» im Dienste einer offenen Suche nach praktischen Anwendungen. «Dabei fasziniert nicht die Herkulesaufgabe, sondern die imposante Erscheinung der Lokalitäten», kommentiert Olof Hallonsten. «Ich sehe vom Fenster meines Büros an der Universität Lund auf die Baustelle. Die imposanten runden Gebäude haben etwas Majestätisches. Ein ideales Bühnenbild für Politiker, die sich vor den Kameralinsen die Hände schütteln.»

Der Gigantismus könnte aber auch kontraproduktive Effekte mit sich bringen, befürchtet der schwedische Forscher. «Eine Gefahr besteht darin, dass die Investitionen in die eindrücklichen Infrastrukturen auf Kosten der Finanzierung der Forschungsarbeit gehen. In Schweden gab es schon Politiker, die gegenüber der Forschungsgemeinde verkündeten: Wir haben alle Mittel in die ESS gesteckt, Sie haben Ihren Teil der Ressourcen also gehabt!» Umgekehrt hat die dänische Regierung – nach ebenfalls substanziellen Investitionen ins Projekt – angekündigt, dass sie für jeden Euro, der in die ESS geflossen ist, einen weiteren Euro zur Finanzierung der Forschungsarbeit mit dieser Infrastruktur bereitstellt. Die moderne Big Science hat wenig gemeinsam mit den eingleisigen Projekten der Vergangenheit, sie bietet vielmehr ein ganzes Bündel von Möglichkeiten.

Nic Ulmi ist freier Journalist und wohnt in Genf.