Fokus: Emotionen nüchtern betrachtet

Ob intelligente Maschinen akzeptiert werden, entscheidet das Vertrauen

Wenn Menschen mit Maschinen interagieren, ärgern sie sich auch mal über sie. Oder fühlen sich ihnen im Gegenteil sehr nahe. Das eine ist kontraproduktiv, das andere kann sowohl sinnvoll sein, als auch ausgenutzt werden.

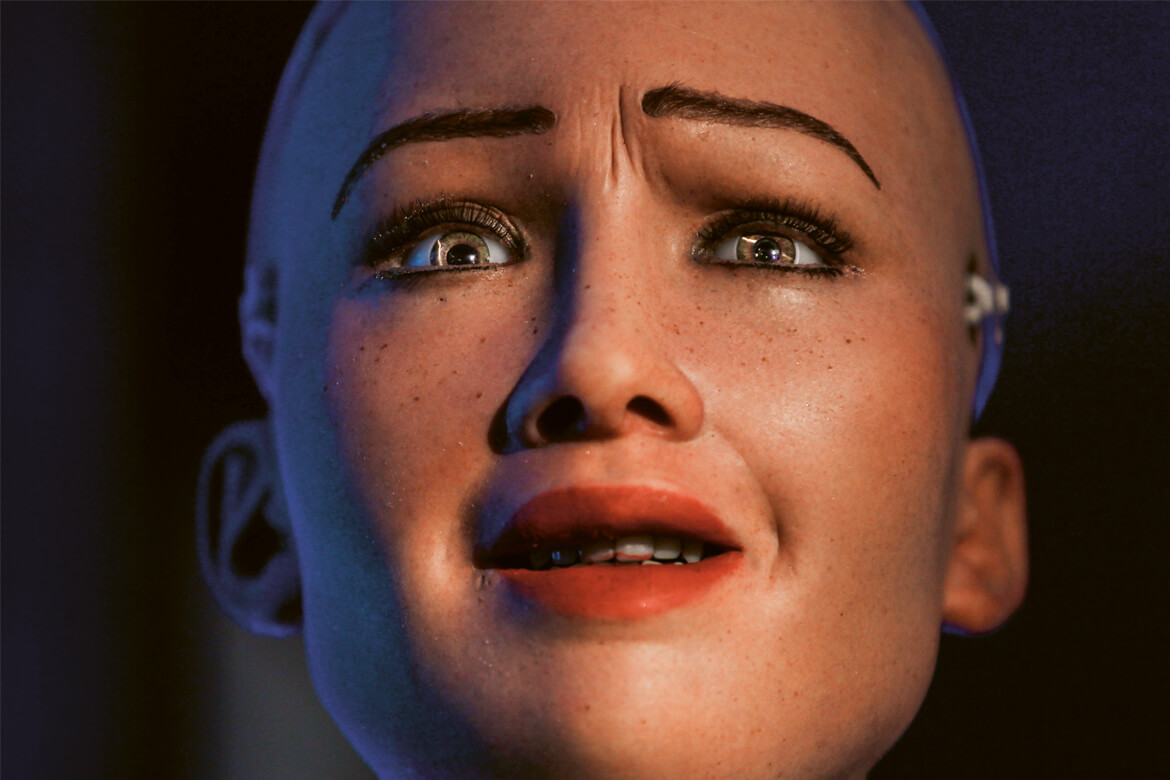

Sophia wirkt gruselig. Die Theorie des Uncanny Valley besagt, dass die Akzeptanz für menschenähnliche Maschinen ab einem bestimmten Grad der Ähnlichkeit sinkt und erst ab einer sehr hohen Qualität wieder steigt. | Bild: Keystone/AP Photo/Niranjan Shrestha

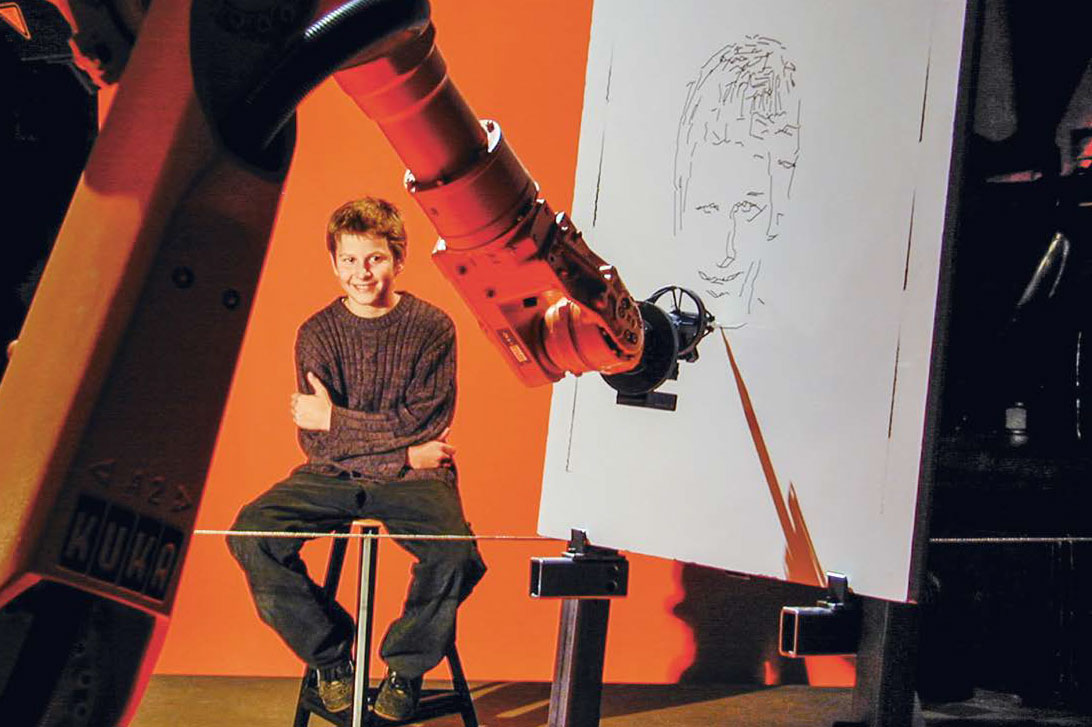

Beschimpfen Sie Ihren Computer, wenn er nicht so funktioniert, wie er soll? Amüsieren Sie sich, wenn die Sprachassistenz-Software auf Ihrem Handy absurde Antworten gibt? Wünschen Sie gar Ihrem Rasenmäh-Roboter gute Nacht, wenn er sich an der Ladestation «schlafen legt»? Dann sind Sie damit nicht allein: «Der Mensch hat eine natürliche Neigung dazu, Maschinen wie menschliche Wesen zu behandeln», sagt Martina Mara, Professorin für Roboterpsychologie an der Universität Linz. Das liegt daran, dass das menschliche Gehirn auf soziale Interaktionen gepolt ist und unwillkürlich auf entsprechende Schlüsselreize reagiert, zum Beispiel Bewegung: Fährt der Rasenmäh-Roboter zufällig auf uns zu, will er vermeintlich Kontakt mit uns aufnehmen. «Es braucht sehr wenig, damit wir den Eindruck bekommen, Maschinen hätten Absichten und Gefühle», sagt Mara.

Stolz auf die Spielfigur

Und nicht nur das: Sie lösen auch Emotionen in uns aus, wenn uns völlig bewusst ist, dass es sich nicht um Lebewesen handelt. Das bestätigt die Psychologin Elisa Mekler, die den Forschungsschwerpunkt Mensch-Maschine-Interaktion an der Universität Basel leitet. Sie erforscht unter anderem, welche Beziehung Probanden zu Figuren in Computerspielen aufbauen: «Die Gefühle, die sie beschreiben, sind zum Teil erstaunlich intensiv.» Es sind die gleichen, die man gegenüber Menschen haben kann. Sie reichen von Sympathie und Stolz bis hin zu Angst und Schuldgefühlen, wenn der Spielfigur etwas Schlimmes zustösst.

Und emotionale Erlebnisse – sowohl positive wie auch negative – bleiben sehr gut im Gedächtnis haften. Ist beispielsweise das Einkaufen in einem Online-Shop mühsam, weil man sich nicht zurechtfindet, oder versteht der Assistenz-Roboter nicht, was man von ihm will, ist der Kunde verärgert oder frustriert und wird das entsprechende Produkt nicht mehr verwenden. «Deshalb haben Designer und Hersteller ein grosses Interesse daran, Produkte so zu kreieren, dass sie positive Gefühle erzeugen », sagt Mekler.

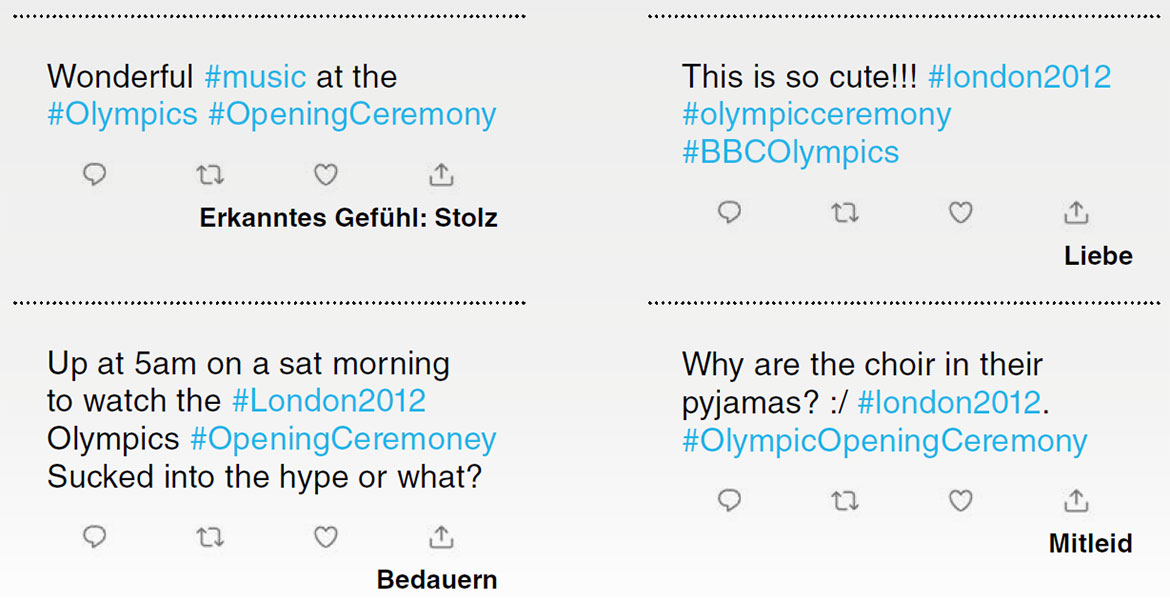

In Facebook-Posts, Forum-Beiträgen oder Kommentaren auf Webseiten drücken User oft ihre Ansichten und Gefühle aus. Diese Informationen maschinell zu extrahieren kann von grossem Nutzen sein: So lassen sich bereits heute anhand von Tweets Vorhersagen über den Ausgang von Wahlen machen. Oder Firmen bringen mit Hilfe entsprechender Software in Erfahrung, ob Kunden ihrer Marke gegenüber positiv oder negativ eingestellt sind. Und bestimmte Algorithmen erkennen an der Wortwahl in Facebook-Posts, ob jemand depressiv ist. Für die Analyse verwenden die meisten Ansätze manuell erstellte Sammlungen von Wörtern, die bestimmte Gefühle signalisieren, oder sie stützen sich auf maschinelles Lernen. Viele Methoden sind relativ genau, wenn es lediglich um die Unterscheidung von positiven und negativen Gefühlen geht. Die Aufschlüsselung einzelner Emotionen wie Freude, Ärger oder Trauer ist hingegen schwieriger, insbesondere, wenn diese nur implizit ausgedrückt werden. So gelingt es kaum, zweideutige Wörter korrekt zuzuordnen, Ironie zu erkennen oder den Kontext zu berücksichtigen. Um diese komplexen Aufgaben zu bewältigen, setzen einige Forschungsansätze nun auf die ausgeprägte Lernfähigkeit tiefer neuronaler Netzwerke, eine hoch entwickelte Art des maschinellen Lernens, das komplexe, nicht lineare Probleme lösen kann.

Von Emoticons lernen

Das Forschungsteam um Pearl Pu von der EPFL hat in 50 000 Tweets über die Olympischen Spiele in London 2012 die Emotionen interpretiert. Der Algorithmus wurde mit der Methode «distance learning» entwickelt: Er analysierte die Hinweise in den Tweets selbst, zum Beispiel Emoticons, bevor er sie generalisierte und auch auf Tweets anwandte, die nur aus Texten bestanden. Wie man in den Beispielen unten sieht, hat er gewissen Erfolg.

Das ist auch eines der Ziele des sogenannten affective computing: Künstliche Intelligenz soll lernen, menschliche Gefühle zu verstehen und angemessen darauf zu reagieren – oder sogar selbst Emotionen zu simulieren. Um Gefühle zu entschlüsseln, stützen sich Algorithmen auf verschiedene Informationsquellen, etwa Gesichtsausdrücke, physiologische Parameter wie Hauttemperatur und -leitfähigkeit oder die menschliche Stimme. Wieder andere versuchen, Emotionen in Texten zu erkennen (siehe Kasten).

Die Anwendungsmöglichkeiten sind vielfältig: Bereits sind kamera- und sensorbasierte Systeme in Entwicklung, die künftig detektieren sollen, wann ein Autofahrer müde oder wütend ist, und ihn dazu auffordern, eine Pause einzulegen. Auch gibt es empathisch scheinende Algorithmen wie den arabisch sprechenden Chatbot «Karim » der Firma X2AI, der syrischen Flüchtlingen mit posttraumatischen Belastungsstörungen Hilfe bieten soll. Und in nicht allzu ferner Zukunft könnten emotionssensitive Pflegeroboter erkennen, ob eine Patientin verängstigt oder aufgeregt ist, und ihr Verhalten entsprechend anpassen.

Computer macht sich scheinbar lustig

Bisher funktioniert die Emotionserkennung zwar im Ansatz, doch gehen oftmals Kontextinformationen verloren. So ist es beispielsweise kaum möglich zu unterscheiden, ob jemand aus Freude oder aus Verlegenheit lächelt. «So kommt es leicht zu Missverständnissen zwischen Mensch und Maschine», sagt Mireille Betrancourt, Professorin für Informationstechnologie und Lernprozesse an der Universität Genf. Betrancourt erforscht im Projekt EATMINT, wie bei der computergestützten Zusammenarbeit von Teams Emotionen entschlüsselt oder von Usern selbst an ihr Gegenüber übermittelt werden können.

Wesen zu behandeln.»Martina Mara

In einem von Betrancourts Experimenten war ein Proband frustriert, weil er eine Aufgabe nicht lösen konnte. Der Computer gab ihm daraufhin die unpassende Antwort: «Wie amüsant!» Das verärgerte den Probanden, und er brach die Kommunikation sofort ab. «Inadäquate Reaktionen führen zu einem Vertrauensverlust », sagt Betrancourt. Deshalb sollten emotionssensitive Systeme absolut korrekte Schlüsse ziehen. Solange das nicht möglich ist, ist es aus ihrer Sicht besser, die Nutzer selbst nach ihren Gefühlen zu fragen, als sie indirekt aus Daten abzuleiten.

Maschine entlockt sehr Persönliches

Es ist also Vertrauen notwendig, damit sich Menschen auf intelligente Technologien einlassen. Manchmal ist das Vertrauen dann sogar grösser als gegenüber Menschen, was für therapeutische Zwecke wertvoll sein kann. Das verdeutlicht eine amerikanische Studie mit Kriegsveteranen, die Gespräche mit einer virtuellen Therapeutin führten, einem Avatar namens Ellie. Erhielten die Probanden die Information, dass Ellie rein computergesteuert ist, gaben sie ihr mehr von ihren schambesetzten Erinnerungen preis, als wenn sie hinter dem Avatar einen Menschen wähnten – weil sie nicht fürchten mussten, moralisch verurteilt zu werden.

Das Beispiel zeigt jedoch auch, welche Risiken ein zu grosses Mass an Vertrauen birgt: «Systeme, die menschenähnlich interagieren, können uns leicht sehr persönliche Informationen entlocken», sagt Psychologin Mekler. Das wirft bisher ungelöste Fragen bezüglich Persönlichkeitsund Datenschutz auf. Das gleiche gilt für Technologien, die Gefühle automatisch erkennen: Wie sicher sind die Daten, die das emotionssensitive Auto oder die Stimmanalyse- Software über mich sammelt? Wer hat Zugriff darauf? Eine Studie der Universität Siegen zeigt: Potenzielle Nutzer erwarten, dass ihre Daten sicher gespeichert und nicht an Dritte weitergegeben werden. Nur unter dieser Bedingung wären sie bereit, emotionssensitive Technologien zu nutzen.